3DCG、VFX、あらゆる映像制作に必要な技術を1年かけて基礎から学ぶ

本科CG/VFX専攻内に設けられたTech Lab2018 ゲーム映像VRゼミ。

VR制作において大切な企画・発想の授業を受講し、新しい体験を創造するクリエイターに必要な思考力を鍛えます。入学より9ヶ月のタイミングでVR作品実装のためのハンズオン授業を受講し卒業制作に備えます。

今回は、オートデスク株式会社 技術営業本部M&Eマネージャーの門口 洋一郎氏をお招きし、『人を魅了するコンテンツ制作をするためのノウハウ「VR and more」』と題して授業をおこなっていただいた様子を、本科CG/VFX専攻ならびに本科UI/UXD専攻受講生の岩本尚也さんにレポートしていただきました。

こんにちは。2018年4月入学で本科CG/VFX専攻、及び本科UI/UXD専攻の岩本尚也です。

今回、【本科CG/VFX専攻 TechLab2018 ~ゲーム映像VRゼミ~】の初回講義として、Autodeskの門口氏をお迎えし、「人を魅了するコンテンツ制作をするためのノウハウ「VR and more」というタイトルで特別講義が行われました。

その内容を皆さんに、お届けしたいと思います。

▼Introduction

Autodeskでは、どんなことをしているの?

Autodeskについて

Autodeskと言えば、Maya、3dsMaxが馴染み深いですが、

”MAKE ANYTHING”

という会社のコピーの如く、デジタルファブリケーション向けツールやエンジニアリングツール等、そのサービスは200を超えるとも言われてます。

講師:門口 洋一郎氏/オートデスク株式会社 技術営業本部M&Eマネージャー

商業用3DCGソフトSoftimage 3Dの技術サポートからスタートし、 現在はオートデスクにてMayaや3ds Max、 Shotgun、 Arnoldなどコンテンツクリエーションツールの技術チームを取りまとめている。 本業の傍らデジタルツールを使った産業用ロボットやドローン制御、 CTデータの可視化やそれまで導入が難しかったリアリティキャプチャーのワークフローなどを提供している。

今回の講師である門口氏は、バーチャファイターやメタルギアといったタイトルの技術サポートをされていたり、1995年では珍しかったトゥーンシェーダや光学式モーションキャプチャを使用したセーラームーンの3DCG映像制作など、CGの黎明期と共に歩んできた方であります。今回の特別講義の中では、自己紹介と併せてAutodeskで取り組んだ最近のAI技術の取り組みをご紹介いただきました。

Generative Design

最近ではHoudiniといったツールを用いることでプロシージャルモデリングが用意に行えるようになってきていますが、より複雑なデザイン、たとえば物体の素材や構造、その他の条件が複雑に絡んだモデリングは未だに困難といえます。そこでオートデスクでは、実験的にトロントのオフィスをソフトウェアによってデザインする取り組みを行いました。ユーザーはソフトウェアに様々な条件(人がオフィス内を歩く距離であったり、音の伝搬、日照条件)を入力し、ソフトウェアによって提案されたいくつかの候補の中から人の手によって一つに絞っていったそう。最終的に完成したオフィスは、なんとエアコンの場所を条件に加えていなかったために部屋が熱くなりすぎて使えなかったそうですが、それでもこういったさまざまな条件を元にしてデザインを最適化していくプロセスは、私たちには創造できないようなデザインや気付き、そして豊かさを提供してくれる未来の第一歩であると思います。

Maya上でのAIの利用

続いては、IBMのWatsonと呼ばれるスーパーコンピュータを用いたMayaとの連携に関するプロトタイピングについて。Watsonが自然言語処理が得意というのを考慮し、「ボックスをつくる」「スケールを二倍にする」「カメラを全体が見えるようにする」といった、言語ベースでモデリングしていく技術をご紹介いただきました。そういったアプリケーションは、マウス操作やキーボード操作が要らなくなるため、PC操作に慣れていないユーザーでも直感的にモデリングができるようになりそうです。このプロトタイプでは、現状クラウドネットワークに接続しながら言語処理を行う必要があるそうですが、今後5Gによる高速通信技術が発展することで、より多くの情報をやり取りしながら高度なモデリングをしていくことが可能になっていくのではないでしょうか。

Maya上でのCaffeモデルの使用

三つ目に、Deep Learningのフレームワークの一つであるCaffeを用いた取り組みを紹介していただきました。その事例では、OpenPoseと呼ばれる動画から人体の骨の位置を推定できる技術をMaya上に組み込むことで、読み込んだ動画ファイル(画像シーケンス)から3次元の骨を推定するプロトタイプの動画を見せていただきました。通常、キャラクタをアニメーションさせる場合、高価なモーションキャプチャ装置や手付けでのキーフレームアニメーションなど、コストや手間がかかってしまいますが、この技術によってより手軽にキャラクタに動きを与えることができるようになります。現状OpenPoseで取得できるボーンの数は非常に少ないため、ゲームエンジン向けのシンプルなボーン配置のキャラクタが適切だそうですが、今後、Inverse Rig Mappingなどの技術によって複雑なリグが仕込まれたキャラクタにリターゲットが可能になれば、制作効率は格段にアップしていきそうです。

門口氏に伺ったところ、現在Autodesk社内では、Mayaで作り込んだ複雑なリグのキャラクタ情報をUnityに持っていく試みも行っているそうで、それができれば、より表現力の高いアニメーションもUnityといったゲームエンジン上でも実時間に実現できるようになっていくと思われます。

▼Related Works

自己紹介だけですごい情報量ですが、本題はここから。VR関連コンテンツの現状についてお話いただきました。

VRの現状の動向について

まず初めに、Gartnerが毎年公表している技術動向の図を元に、近年のDeep Learning, AR, VRの動向を考察していきます。Gartner 2017では、Deep Learningは今最も期待値が高まっている場所を示している一方、ARは幻滅期にあり、VRは緩やかに上昇する兆しが見られています。そしてGartner 2018では、VRはMixed Realityに統合され、幻滅期の手前に位置が修正されています。そしてARは未だに幻滅期のままです。ここで門口氏は、エンターテインメントとしてのVRがうまくいっていないのは、PS4などのコンシューマゲーム機が8400万台の売上だったのに対し、PSVRは300万台と、まだまだ利用ユーザが少ないことが原因だと指摘しています。市場が小さいと大手のゲーム会社が参入しづらく、会社にとって投資する価値を未だに見いだせていないのが現状で、今は一部のユーザーがVRChat等でコミュニケーションの場として遊んでいるのが主な用途となっているそう。この状況は、一昔前の3Dプリンターと似ており、決して悲観することはないそうです。というのも、近年3Dプリンターの技術は製造プロセスに大いに活かされており、今後VRも緩やかなペースながらも様々なシーンで利用されていくことが期待できるそうです。

エンターテインメント分野でのVR事例

例えばドリームワークスでは、ヒックとドラゴン2(日本では公開されていない)の製作において、ヘッドマウントディスプレイなどのハードウェアデバイスとAR, VR技術を組み合わせることで、コストを抑えながら効率的に映像制作をする試みを行っているそう。講義の中で見た映像では、カメラ位置を三次元でトラッキングしながら、作品中のカメラ位置をトライアンドエラーしてる様子が見て取れました。こういったプリビズ工程におけるVR利用も今後の発展の方向性の一つになりそう。

またバーチャルマーケットと呼ばれるプラットフォームでは、ユーザー同士でモノの売り買いが起きているようで、こういったCtoCの流れに企業もビジネスチャンスがあるのではと、門口氏は言います。またバーチャルユーチューバーも現在4000人程度とすべてを把握できないくらいまで発展してきており、今後実時間での全身動作の制御が可能なプロトコルが開発されることで、より安価に誰でも楽しめるコンテンツになっていく可能性があります。現在はテレビ越しで一方的に見ている芸能人も、今後はバーチャル空間上で見て、コミュニケーションが取れるようにもなっていくのではないでしょうか。そういったバーチャルアバター同士のコミュニケーションを実現する上で必要不可欠な全身の動きや顔の表情のキャプチャ技術に関しても、iCloneといったソフトウェアを用いたテスト事例を紹介いただきました。

複雑なアニメーションの実時間表現について

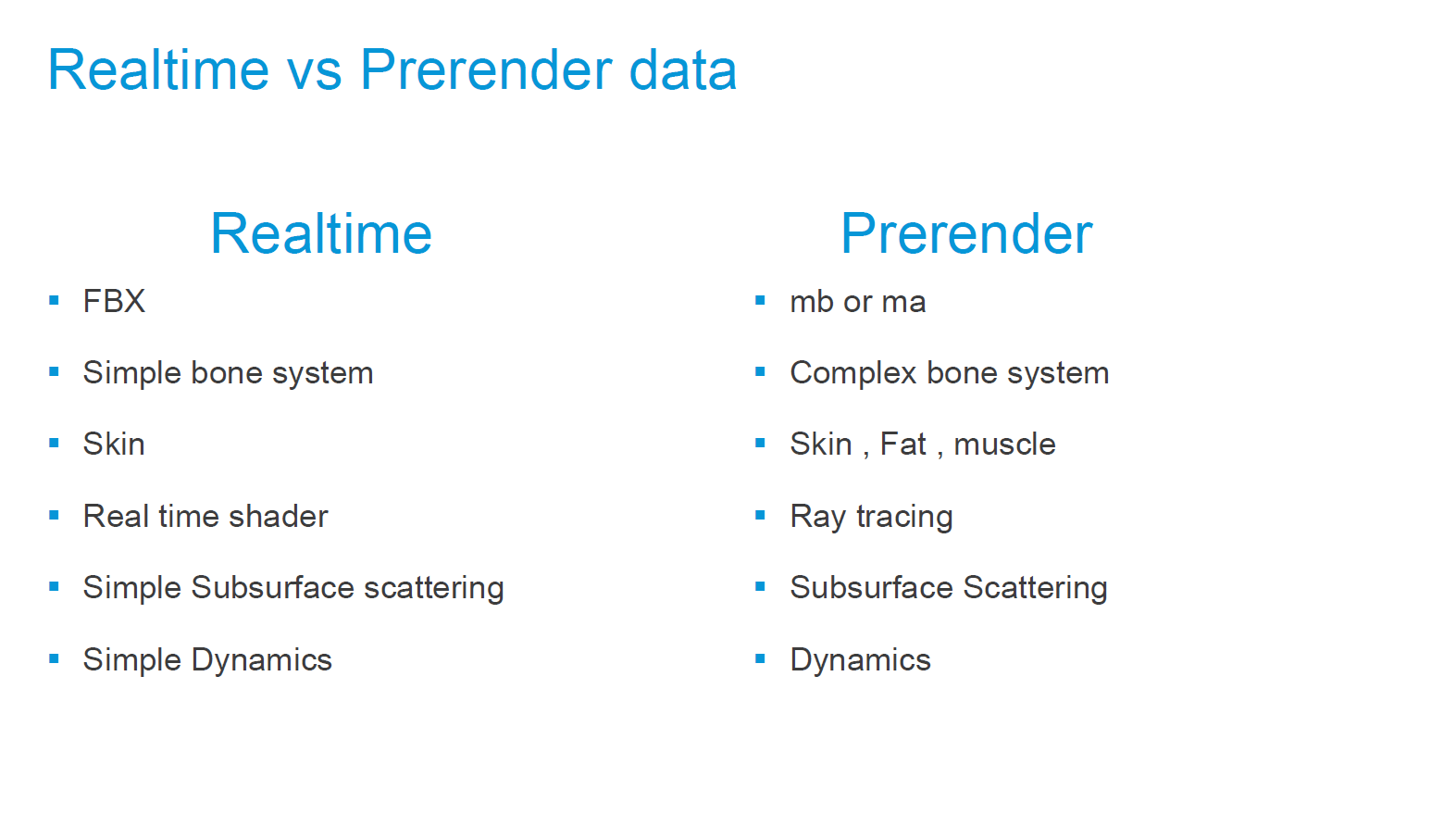

ここからは、RealTime と Pre Renderの違いを比較しながら、現在の最先端映像表現の一部を覗いていきます。門口氏は、はじめにBRADE RUNNERを例を取り上げながら、(本人にそっくりなデジタルアバターを再現する)デジタルダブル技術を紹介。講義はこういったハイクオリティなキャラクタアニメーションをリアルタイムエンジンでどう表現していくかという話題へ。

そこで重要となってくるのが各データフォーマットによって再現できる情報について。講義ではFBX(Autodeskが開発したアニメーションフォーマットで、Unity等のデータ間のやり取りで頻繁に用いられる)と.ma, .mb(Mayaのデータ・フォーマット)について説明していただきました。

上記のスライドで記載されているように、FBXではMaya上で計算される複雑なボーンシステムやスキンのスライド、脂肪、筋肉といった情報を再現する事が困難です。そこで一つの方法として、Maya(やHoudini)で作ったジオメトリやアニメーション情報をAlembic(ILMなどの企業が開発した形式で、頂点データの情報が記述されている)で出力することによって、複雑な動きをゲームエンジンで再現可能となります。

キャプテンハーロックなどを製作したMarza Animation Planetが手がけたアニメーション「The Gift」では、Alembic形式を使ってとても実時間とは思えない高精細な映像表現を実現しています。レンダリングやライティングはゲームエンジンを使用し、すべて実時間で計算しているというので驚き。

また、Oats Studioが製作したAdamシリーズでもUnityを使用した同様のプロセスによりここまでのクオリティが実現できているそう。なお、この作品の中で表現されている衣服や表情といった複雑な制御が必要な情報は、MayaやHoudiniで作成されたものをAlembicで出力し、Unityで再現し、ボディのスキニングはシンプルなものでよいという判断により、FBXのボーン情報として書き出されているそうです。

これらの方法では、事前に複雑なアニメーションは計算済なので、実時間での計算量はかからないというメリットがありますが、最初にそういった情報をメモリに読み込むため、大量にメモリが消費されるという欠点があります。今後そういった問題が様々な技術によって解決していくことで、より幅広い表現ができていくことが予想されます。

マテリアル情報の共通化の流れ: MaterialX

これまでは、Alembicを用いることで複雑なアニメーションをリアルタイムエンジンに持っていくことができるという話でしたが、レンダリングに関しては、マテリアル情報をうまく合わせないと同じ結果が得られない点が大きな課題となっています。そこで、複数のソフトウェア間(例えばMayaとUnity)でのレンダリング結果のギャップが小さくなるようなマテリアル情報における取り組みが行われています。

ILMが提案したMaterialX[関連情報]は、異なるソフトウェア間でのマテリアル情報を共通化できる互換性を持ったオープンソースライブラリで、Autodeskを始め、PixarのUSD[関連情報]、DisneyのBRDF[関連論文]で使用されているそう。門口氏は、講義の中でMayaのArnoldでレンダリングしたものとKatanaでレンダリングしたものを比較しながら、MaterialXを経由することで同じShader情報として変換する事が可能であることを示していました。

こういった取り組みもあり、映画で作ったアセットをゲームエンジンに持ってくることがより効率化されてきています。ILMxLabの「Secrets of the Empire」は、スターウォーズ ローグワンで使用したアセットを用いてUnreal Engine上で制作された作品だそうです。

▼Autodesk社内でのエンターテインメントプロジェクトについて

ここまでは、様々なエンターテインメントコンテンツがどのような制作プロセスで行われているかをご紹介いただきました。そしてここからはオートデスク社内で門口氏がかかわったプロジェクトについてご紹介いただきました。

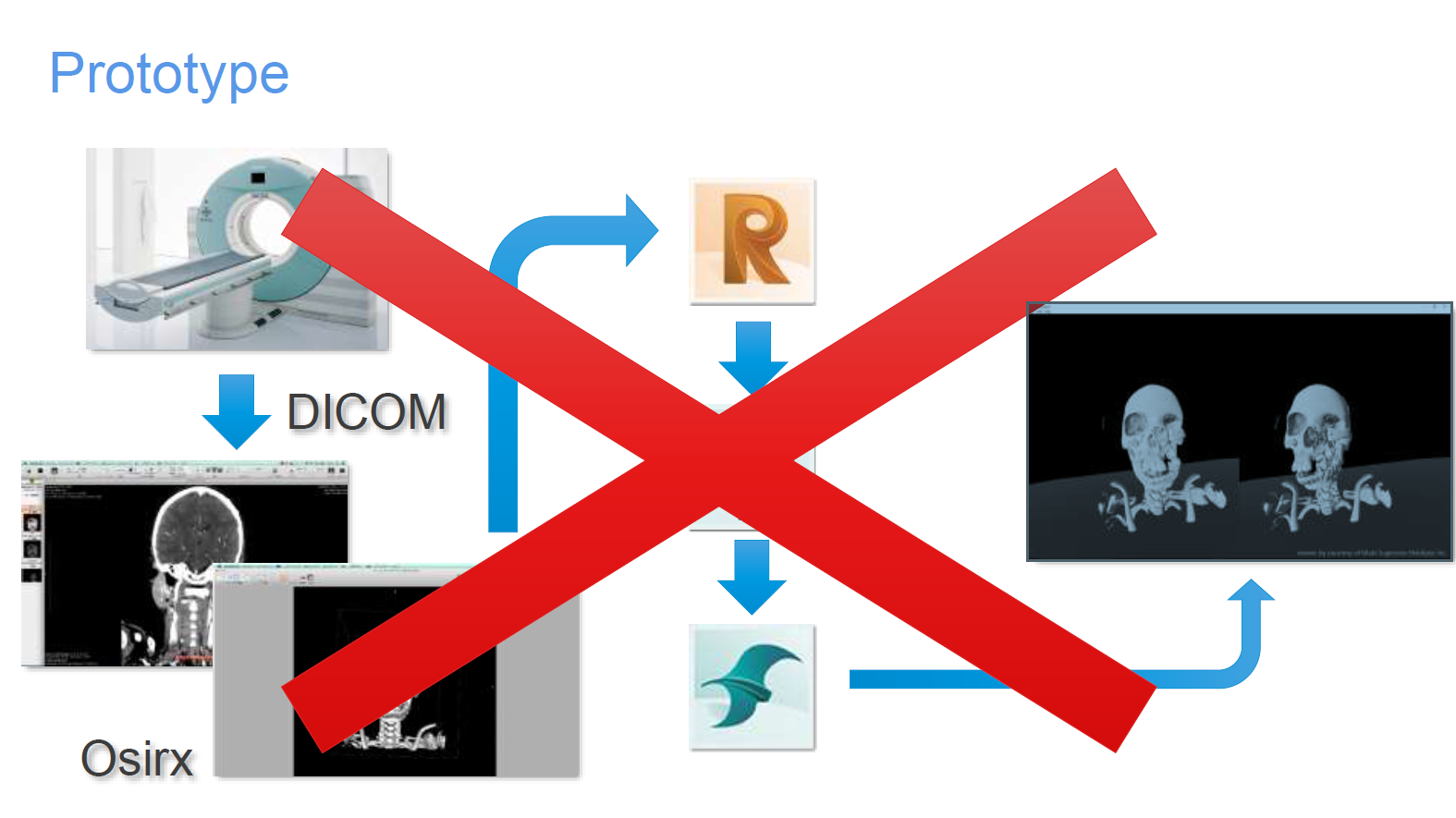

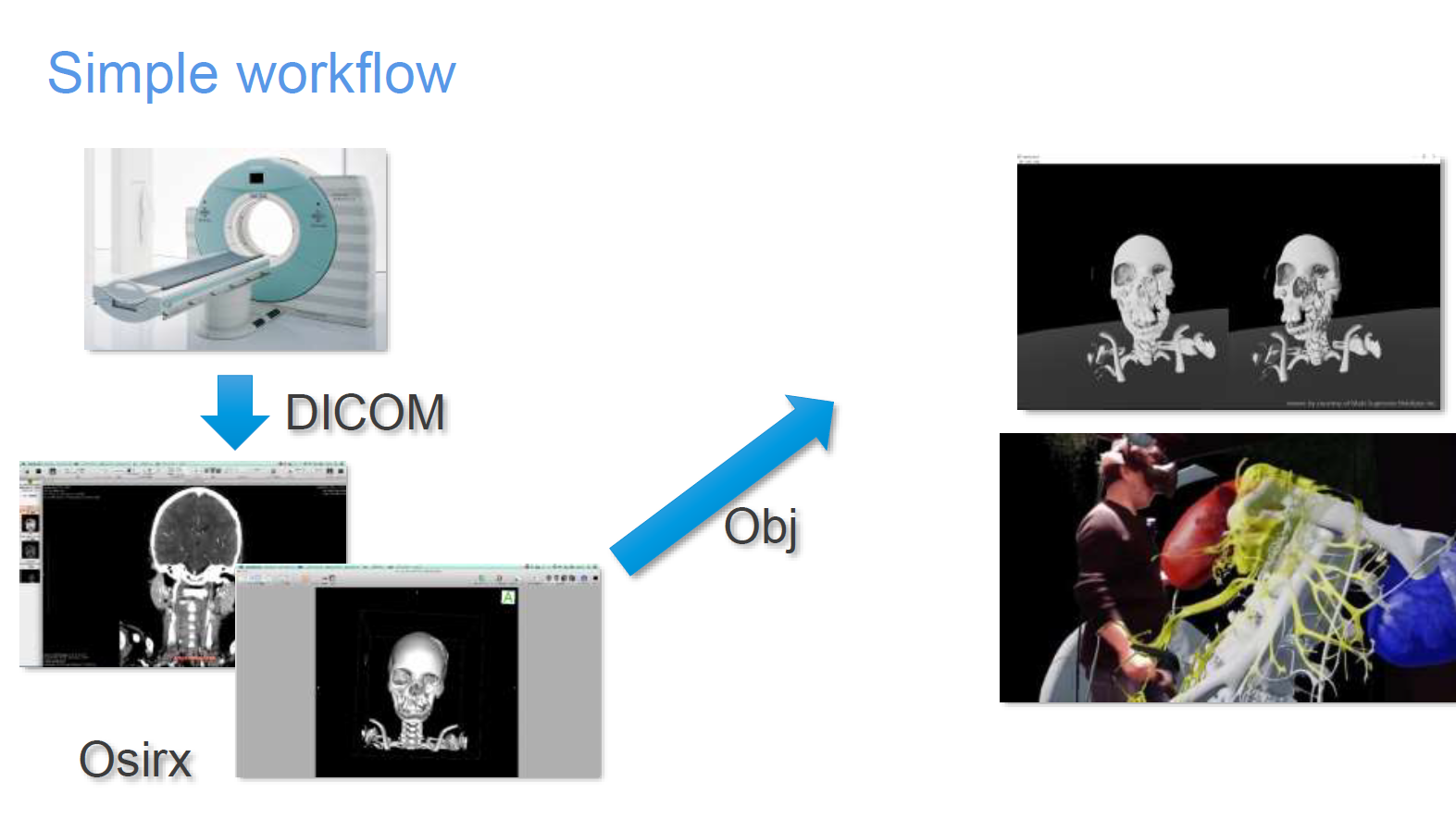

VR for Medical

まずはじめに、門口氏がHoloeyes COOの杉本真樹氏と協力して行ったCTデータの可視化に関するプロジェクトをご紹介頂きました。CTで取得したデータをVRで可視化するためには、既存の方法だと処理と書かれた部分が非常に手間のかかるポストプロセスとして生じてしまいます。

そこで門口氏らはObjVR-Viewerというものを開発し、Osirxのボリュームデータを実時間で処理しながらVR上でメッシュとして表示できるようにしました。

HTC VIVEをコントローラーとして使用することで、そのモデルに触れながら様々な角度で3Dモデルを見ることができます。

Reality Capture (Photogrammetry)

そして話は実写画像を用いたモデリング技術、フォトグラメトリーへと移っていきます。話は旧タリバン政権に破壊されたアフガニスタンの世界遺産、バーミヤン遺跡について。紹介いただいたプロジェクトは、遺跡が破壊される前の画像を集め、その写真から三次元復元するというものです。その際に使用されたのがAutodeskのRecap。こういった三次元復元技術は近年では歴史的建造物や人工遺物と自然的遺物などの保存に役立っており、博物館の中では3Dデータをウェブ上で公開しているところもあります[ 関連情報]。今後こういった取り組みは、公共施設レベルだけでなく、スマートフォン上で個人レベルで実現できるようになっていくと思います[ 関連情報]。

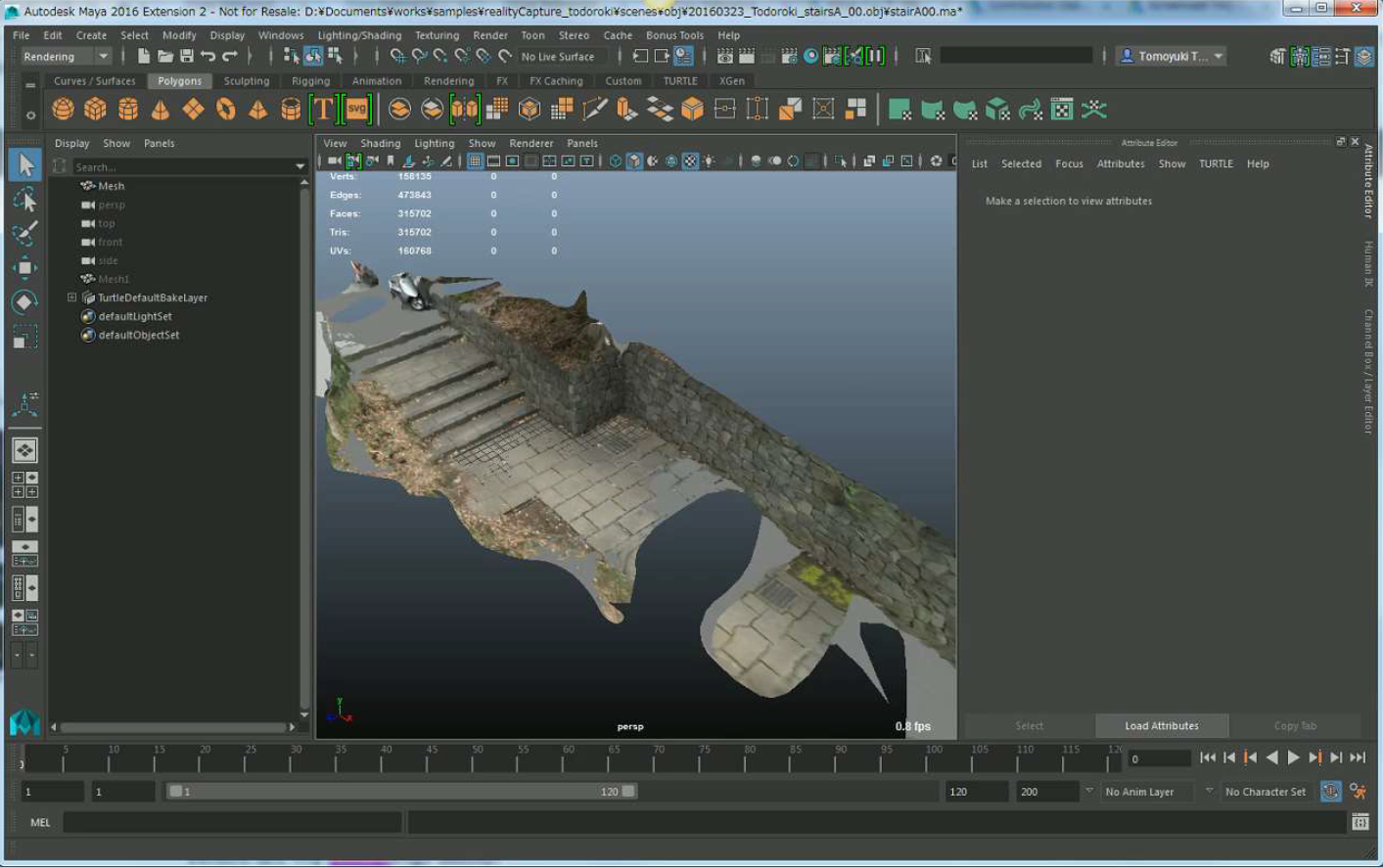

門口氏が実際に行った試みとして、等々力公園で撮影した複数枚の写真から3Dのメッシュを生成するテストの模様を見せていただけました。復元したメッシュは非常に密度が高いため、ゲームエンジンに持っていくために、頂点数を削減し、テクスチャのUVも調整しながら、最終的にテクスチャをRebakeする事で軽量化しながらクオリティをそこまで落とさずにゲームエンジン上で表示できています。

続いてMedia Ambition Tokyo2017というイベントにて、ライゾマティクスと行ったプロジェクトをご紹介頂きました。こちらは、東京都が作っている立体の立体の地図を、物理的にいじらずに、拡張現実空間上で地図を更新して行こうというプロジェクトです[ 関連情報 ]。

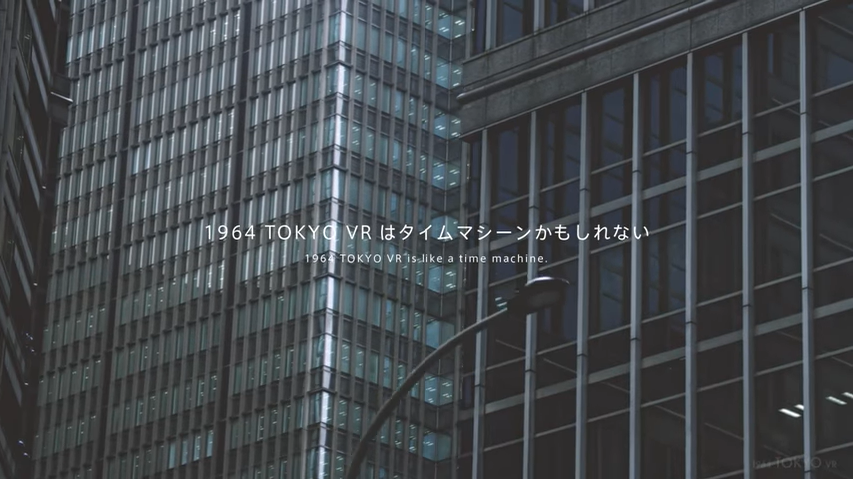

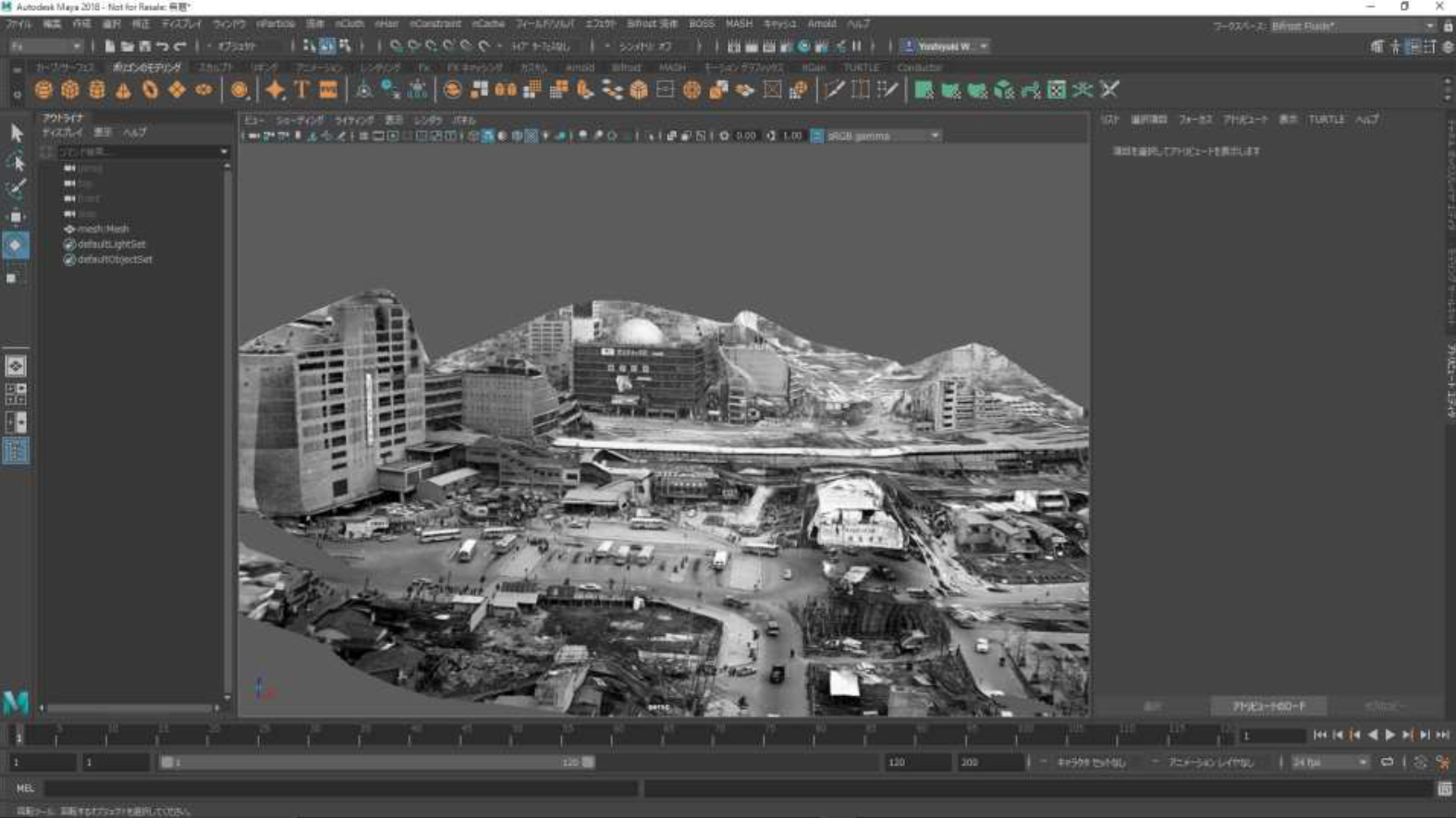

その流れで、東京オリンピックが東京で最初に行われた1964年当時の東京を再現するプロジェクトへと話は移っていきます[ 関連情報]。

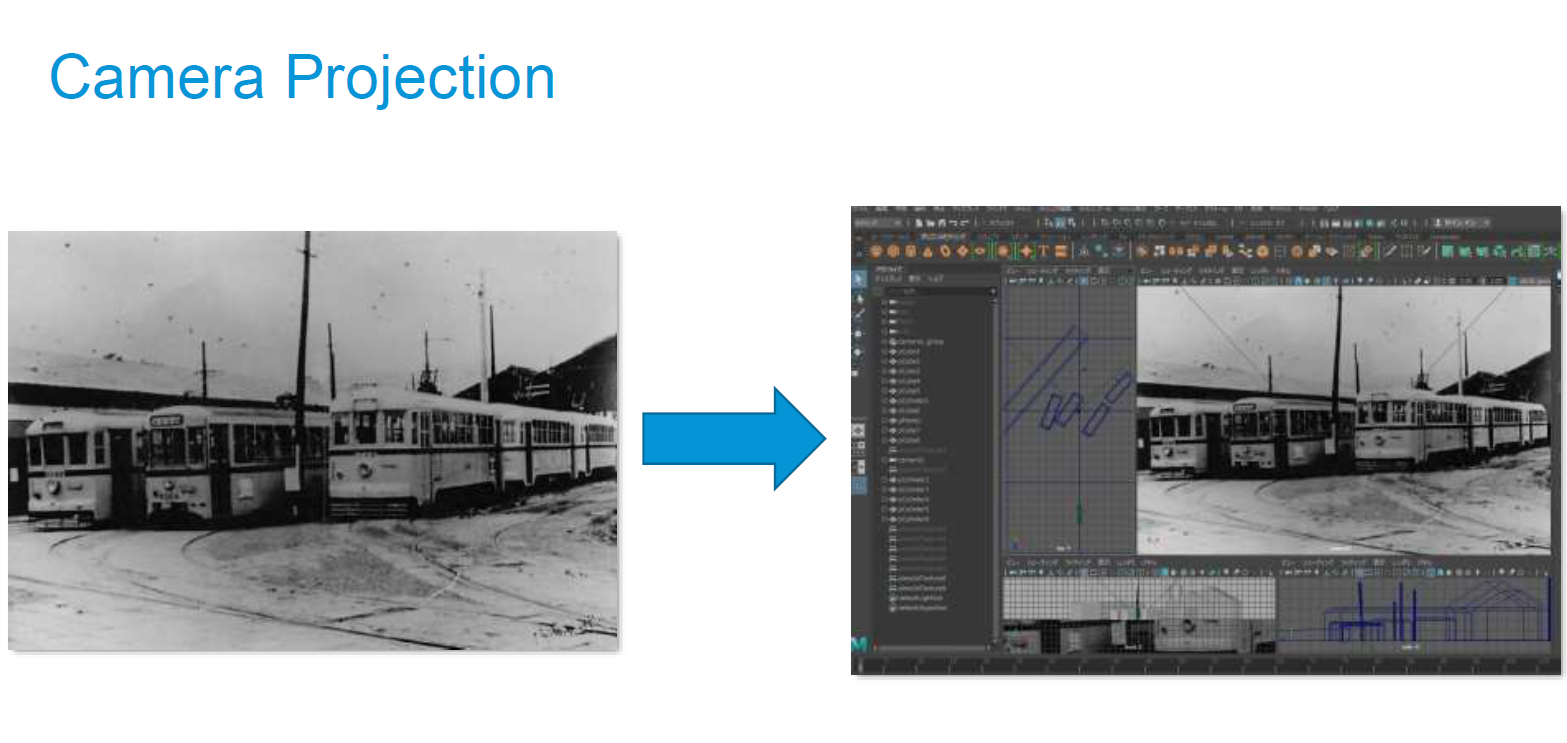

このプロジェクトでは、1964年の町並みを当時の写真から再現するという試みで、当時の街の写真を各所から集め、最初に地域、年代、撮影状況(ヘリコプター、陸など)を分類、ソート化したそうです。その中で写真がボケているものはAdobe Senseiなどを使用して補正。対象の建物が写った写真が複数枚あればその複数枚の視差から三次元形状を復元でき、また写真が複数枚ないものに対しては、その一枚の写真をもとにアーティストの手作業によってモデリングし、プロジェクションマッピング(技術的にはプロジェクティブテクスチャ)によって、テクスチャを貼り付けるなどして対応したそうです。

▼感想

今回の講義では、Autodesk社内でのAIを用いたプロトタイピングから、近年のVR関連のコンテンツの動向とその製作手法、そして門口氏が関わったプロジェクトについてご紹介いただきました。

講義を通じて、目的に応じてツールを使い分けることや適切なフォーマットでのツール間のやり取りが効率的な映像製作や実次元での高度な表現に非常に大切であることがわかりました。また、門口氏が関わったプロジェクトを通じて、映画やゲームといったコンテンツとはまた異なるソーシャルグッドなプロジェクトへの可能性も強く感じました。個人的には、国立競技場の最後の日に行った「 SAYONARA 国立競技場 」や、アイルトン・セナの走行データから当時のレースを蘇らせるプロジェクト「 Sound of Honda / Ayrton Senna 1989」など、当時の物や人を現代に蘇らせるプロジェクトが当時とても印象的だったこともあり、より私たちの生活や心を豊かにしていくようなプロジェクトに関われたらいいなと思います。

▼受講生の感想もご紹介

岩本さんと共に受講していた、受講生の方々からも

・事例の紹介など、非常に興味深い内容ばかりでした!

・VRのコンテンツの可能性と、その応用についてさらに学びたいと思いました。

・制作の中で、リアルタイムという部分とどう付き合っていくのかを考えるきっかけになりました。

など、みなさん自身の学びがどうやって活かせるのかを知る良い機会となり、大変やる気が出る授業となったようです。

いかがでしたか?

デジタルハリウッド東京本校では、受講生のみなさんに様々なことを学んでいただけるよう、通常授業と合わせて特別講義もご受講いただけるよう授業を実施しております。

今後も、受講生の目指す目標をサポートできるよう、様々な授業を展開していきます!レポートもどんどんしていきますので、どうぞお楽しみに!

[Tech Lab2019]ゲーム映像VRゼミを受講できるコースのご紹介

1年間で高いレベルの映像作品をアウトプットできる、デジタルハリウッドの最高峰クラス。

定番のソフトウェアから最新の映像表現まで3DCG制作に必要な技術を学び1年で即戦力へ。将来、国内外の現場で活躍できるプロを育成するコースです。

[Tech Lab2019]ゲーム映像VRゼミ が受講できる本科CG/VFX専攻出願受付中!

スクール説明会(無料)では「カリキュラム」「業界の最新情報」

「就職情報」「通学方法」など専門カウンセラーが丁寧にご案内致します。

※ご予約の際、ご希望のスクールは『東京本校』をご選択ください。